Varianzanalyse (ANOVA)

Dieser Artikel befasst sich mit der Anwendung der Varianzanalyse auf das wichtige und häufig anzutreffende Problem der Bestimmung der Signifikanz der Differenz zwischen den Mitteln.

Die Varianz ist im üblichen Sinn ein Maß für die Streuung einer Menge von Scores. Es beschreibt das Ausmaß, in dem sich die Bewertungen voneinander unterscheiden. Sie ist definiert als der Mittelwert der quadratischen Abweichung der Einzelwerte vom Mittelwert.

wobei x = X - M oder Abweichung der Bewertung vom Mittelwert, dh Varianz = Quadrat von SD

oder Varianz = σ 2, also σ =

Ein Maß der Abweichung gibt uns eine Vorstellung von der Homogenität der Gruppe. Die Varianz des Satzes von Bewertungen ist geringer, wenn die Gruppe hinsichtlich der Leistung homogen ist. Auf der anderen Seite wird die Varianz des Satzes von Scores größer sein, wenn die Gruppe in ihrer Leistung heterogen ist.

Die Varianzanalyse ist ein sehr nützliches Instrument zur Analyse der Ergebnisse wissenschaftlicher Untersuchungen und Forschungen in den Sozial- und Naturwissenschaften. Um Antworten auf Forschungsfragen in experimentellen Studien zu erhalten oder die Hypothesen zu testen, wird die Varianz in verschiedene Komponenten analysiert und die Varianzen aus verschiedenen Quellen werden verglichen. In der Forschung stoßen wir auf ein anderes experimentelles Design und formulieren Nullhypothesen.

Wir verwenden die Technik der "Varianzanalyse" (ANOVA oder ANOVAR), um zu untersuchen, ob das Varianzverhältnis (F) signifikant ist oder nicht, und basierend darauf wird die Nullhypothese entweder akzeptiert oder abgelehnt.

Das Konzept der Varianz und der ANOVA wird durch ein Beispiel verdeutlicht.

Beispiel 1:

Berechnen Sie die Varianz der folgenden Verteilung der Punkte 4, 6, 3, 7, 5.

Hier wird der Ausdruck Zx 2 als „Summe der Quadrate der Abweichung der Ergebnisse vom Mittelwert“ (kurz SS) bezeichnet. Wenn SS durch die Gesamtzahl der Punkte (N) dividiert wird, erhalten wir “Mean Square” oder MS. Daher wird Varianz auch als Mittelquadrat bezeichnet. Symbolisch

V = MS oder V = SS / N

Eine Abweichung in der Terminologie der ANOVA wird oft als "Mean Square" (oder MS) bezeichnet. In der Varianzanalyse (ANOVA) wird das mittlere Quadrat oder die Varianz durch Division von SS durch df berechnet. Somit

Komponenten der Varianz:

Bevor Sie detaillierte Varianzberechnungen durchlaufen, ist ein Blick auf zwei ihrer Komponenten erforderlich:

a) systematische Varianz und

(b) Fehlervarianz.

(a) systematische Abweichung:

Die systematische Varianz in einem experimentellen Aufbau ist der Teil der Varianz, der der Manipulation der experimentellen Variablen, dh der unabhängigen Variablen, zugeordnet werden kann.

Zum Beispiel möchte ein Ermittler die Wirkung der Motivation, dh verbaler Belohnung und Anerkennung, auf die akademische Leistung zweier gleichberechtigter Gruppen untersuchen. Er wählt zwei homogene Gruppen aus und manipuliert die verbale Belohnung für eine Gruppe und die Anerkennung für eine andere Gruppe. Dann führt er einen Test für beide Gruppen durch und erhält ihre Bewertungen.

(Hier ist 'Motivation' die unabhängige Variable und 'erzielte Punktzahl' die abhängige Variable). Wenn die Varianz aller Bewertungen von zwei Gruppen berechnet wird, wird dies als Gesamtvarianz (V t ) bezeichnet. Der Teil der Gesamtvarianz, der nur der "Manipulation der Motivation" zuzuschreiben ist, kann als "systematische Varianz" bezeichnet werden. Dies ist die Abweichung zwischen den Gruppen (oder V b ).

(b) Fehlervarianz:

Neben dem Einfluss experimenteller Variablen gibt es auch andere Variationsquellen aufgrund von Fremdvariablen, die abhängige Variablen beeinflussen können.

Die Fehlervarianz ist somit der Teil der Gesamtvarianz, der anderen unkontrollierten Variationsquellen in einem Experiment zugeschrieben werden kann.

Fehlervarianz ergibt sich aus verschiedenen Quellen, nämlich:

1. Unkontrollierte Variationsquellen, die sich aus fremden Variablen ergeben.

2. Inhärente Variabilität in den experimentellen Einheiten.

3. Zufällige Schwankungen im Experiment.

4. Messfehler wegen fehlender

(a) experimentelle Standardtechniken;

(b) Einheitlichkeit in der Verwaltung;

(c) körperliche Durchführung des Experiments;

(d) vorübergehender emotionaler Zustand der Probanden usw.

Symbolische Fehlervarianz wird als V e ausgedrückt. Im obigen Beispiel befassen wir uns hauptsächlich mit zwei Variablen, nämlich Motivation als unabhängige Variable und Leistungsbewertungen als abhängige Variable.

Neben diesen beiden Variablen trifft der Ermittler auf andere Variablen, die die abhängige Variable beeinflussen. Solche anderen Variablen können wie Geschlecht, Intelligenzniveau, sozioökonomischer Status, Alter, Bildung usw. sein, um die sich der Ermittler nicht gekümmert hat.

Solche Variablen, die in einem Versuchsaufbau nicht kontrolliert werden und das Auftreten von abhängigen Variablen beeinflussen, werden als "externe Variablen" oder "irrelevante Variablen" bezeichnet.

Wenn diese Variablen in einem Experiment gesteuert werden, kann der experimentelle Fehler minimiert werden. Wenn diese externen Variablen nicht gesteuert werden, wird dies den Teil der Fehlervarianz bilden. "Die Hauptfunktion des experimentellen Designs besteht darin, die systematische Varianz zu maximieren, externe Varianzquellen zu steuern und die Fehlervarianz zu minimieren." Daher möchte jeder Forscher den experimentellen Fehler reduzieren.

Um die Fehlervarianz zu minimieren, können folgende Möglichkeiten verwendet werden:

1. Fremdvariablen können gesteuert werden durch:

ein. Randomisierung,

b. Beseitigung,

c. Zusammenbringen,

d. Durch die Einführung zusätzlicher unabhängiger Variablen oder Variablen und

e. Durch statistische Kontrolle.

2. Messfehler können gesteuert werden durch :

ein. Unter Verwendung standardisierter experimenteller Techniken

b. Mit zuverlässigen Messinstrumenten

c. Sicherstellung der Einheitlichkeit bei der Verwaltung oder Durchführung des Experiments

d. Erhöhung der Zuverlässigkeit der Messung durch klare und eindeutige Anweisungen usw.

Die obige Diskussion bestätigt, dass die Gesamtvarianz aus zwei Teilen besteht, dh

V t = V b + V e

wobei V t = Gesamtvarianz ist

V b = Varianz zwischen Gruppen (oder systematische Varianz)

V e = Fehlervarianz.

In ANOVA wird die systematische Varianz gegen die Fehlervarianz mittels F-Test untersucht.

Je größer der Wert von F ist, desto größer ist die Wahrscheinlichkeit, dass die systematische Varianz größer ist als der experimentelle Fehler (innerhalb der Gruppenvarianz oder einzelner Variationen).

Ein numerisches Beispiel kann zwischen systematischer Varianz und Fehlervarianz unterscheiden.

Beispiel 2

Ein Ermittler teilt zehn Gruppen nach dem Zufallsprinzip zwei Gruppen (fünf in jeder Gruppe) zu und manipuliert diese beiden Gruppen nach Belieben mit zwei Motivationsbehandlungen.

Dann führt der Ermittler einen Test durch und notiert die Ergebnisse von zehn Schülern wie folgt:

Es wird nun beobachtet, dass die Mittelwerte zweier Gruppen unterschiedlich sind. Das heißt, wir finden Abweichungen zwischen den Gruppen. Die Zwischengruppenvarianz (V b ) kann wie folgt berechnet werden. Nehmen wir die Mittelwerte 5 und 7 als zwei Punkte und berechnen Sie die Varianz dieser beiden Werte.

Wir berechnen dann die Gesamtvarianz (V t ), indem wir alle zehn Werte beider Gruppen in einer Spalte zusammenfassen.

V t enthält alle Variationsquellen in den Scores. Früher haben wir berechnet, dass V b (oder die Varianz zwischen den Gruppen) 1, 00 beträgt.

Lassen Sie uns nun noch eine weitere Varianz berechnen, indem Sie die Varianz jeder Gruppe separat berechnen und sie dann mitteln.

Da wir die Varianzen separat berechnet und dann gemittelt haben, bezeichnen wir diese Varianz als „innerhalb der Gruppenvarianz“ oder als V w .

In unserem Beispiel ist V w = 3 .8

Also 4, 8 (V t ) = 1, 00 (V b ) + 3, 8 (V w )

oder Vf = Vb + Vw [Gesamtvarianz = zwischen Gruppenvarianz + innerhalb der Gruppenvarianz].

Grundlegende Konzepte der ANOVA:

Bevor wir numerische Probleme aufgreifen, um die Nullhypothese mithilfe von ANOVA zu testen, sollten wir zwei Konzepte kennenlernen, nämlich (a) Summe der Quadrate (SS) und (b) Freiheitsgrad ( df ), auf die wir in der ANOVA oft stoßen würden.

(a) Berechnung der SS (Quadratsumme):

In ANOVA berechnen wir die "Abweichung zwischen Gruppen" (V b ) und die Abweichung innerhalb der Gruppen (V w ). Wir berechnen V b und V w wie folgt:

Dabei ist SS b = Summe der Quadrate zwischen Gruppen

und SS W = Summe der Quadrate innerhalb der Gruppen.

Wir vergleichen diese beiden Varianzen durch ein Verhältnis namens F mit F = wo

Lassen Sie uns nun lernen, wie die Quadratsumme (SS) mit zwei Methoden berechnet werden soll.

Beispiel 3:

Berechnen Sie die Quadratsumme der folgenden Verteilung der Ergebnisse.

7, 9, 10, 6, 8

Mittelwert = 40/5 = 8

Methode II (kurze Methode):

SS kann direkt aus den Bewertungen berechnet werden, ohne Mittelwert und Abweichung zu berechnen. Dies wird als Kurzmethode bezeichnet und SS wird mithilfe der Formel berechnet.

Hier müssen wir nicht den Mittelwert und die Abweichungen der einzelnen Punkte vom Mittelwert berechnen. Die zweite Methode wird bevorzugt, wenn viele Bewertungen vorhanden sind und der Mittelwert Dezimalzahlen enthält.

Daher kann in ANOVA die Summe der Quadrate unter Verwendung der Formel berechnet werden.

Berechnung der Summe der Quadrate zwischen Gruppen (SS b ) und Quadratsumme innerhalb der Gruppen (SS W )

Folgende zwei Methoden können zur Berechnung von SS t, SS b und SS w verwendet werden .

Beispiel 4:

Zwei verschiedene Behandlungen werden an zwei Gruppen von jeweils fünf Probanden manipuliert.

Und die erreichten Werte sind wie folgt:

Der "Große Mittelwert" (dh der Mittelwert aller zehn Bewertungen) sei als M bezeichnet

Nun ist M = 35 + 25/10 = 60/10 = 6

Berechnung von SS t, SS b und SS w (Long-Methode):

Berechnung von SS t :

Um SS t zu berechnen, müssen wir die Summe der Quadrate der Abweichung jedes der oben genannten zehn Werte vom großen Mittelwert (dh 6) ermitteln.

Berechnung von SS b :

Um SS b zu berechnen, nehmen wir an, dass jedes Element der Gruppe gleich seinem Gruppenmittelwert ist, und untersuchen dann die Varianz zwischen verschiedenen Gruppen. Hier berechnen wir die Summe der Quadrate der Abweichung der Mittelwerte verschiedener Gruppen vom großen Mittelwert.

Der Wert jedes Elements in Gruppe-I wird als 7 angenommen, und der Wert jedes Elements der Gruppe-II wird als 5 angenommen und die Summe der Quadrate dieser Werte aus dem großen Mittelwert (M = 6) wird berechnet.

Wir können SS b in einer tabellarischen Form wie folgt berechnen:

Berechnung von SS w :

Für die Berechnung von SS W ermitteln wir die Summe der Quadrate der Abweichung verschiedener Werte einer Gruppe aus dem Mittelwert der jeweiligen Gruppe.

Die Berechnung von SS W wird in Tabellenform dargestellt:

Gesamtsumme der Quadrate oder SS W = 10 + 6 = 16

In der obigen Berechnung haben wir SS t = 26, SS b = 10 und SS W = 16 gefunden

Somit ist SS t = SS b + SS w

Berechnung von SS t, SS b und SS w (Kurzmethode):

In einer kurzen Methode können wir SS t SS b und SS W direkt aus den Bewertungen mithilfe der folgenden drei Formeln berechnen.

Bei dieser kurzen Methode müssen wir den Mittelwert und die Abweichungen nicht berechnen. Wir können verschiedene Abweichungen direkt aus den Bewertungen berechnen. In der ANOVA werden SS t und SS b normalerweise nach der Kurzmethode berechnet.

Während wir Probleme mit der ANOVA aufnehmen, berechnen wir SS und SS t mit dieser kurzen Methode.

(b) Freiheitsgrade (df):

Jede SS wird zu einer Varianz, wenn sie durch die ihr zugeteilten Freiheitsgrade ( df ) geteilt wird. In ANOVA würden wir mit Freiheitsgraden ( df ) stoßen. Die Anzahl der Freiheitsgrade für jede Varianz ist um eins niedriger als das V, auf dem sie basiert.

Wenn N = Anzahl der Bewertungen in allen und K = Anzahl der Kategorien oder Gruppen, gilt für den allgemeinen Fall:

df für Gesamt-SS = (N - 1)

df für zwischen Gruppen SS = (K - 1)

df für innerhalb der Gruppen SS = (N - K)

Ebenfalls:

(N - 1) = (N - K) + (K - 1)

Varianzanalyse (Einweg):

Separat haben wir über Tests der Signifikanz des Unterschieds zwischen den Mitteln diskutiert. Normalerweise wird der t-Test verwendet, wenn wir feststellen wollen, ob sich die beiden Stichprobenmittel signifikant unterscheiden.

Wenn wir uns mit den Experimenten befassen, die zwei Gruppen umfassen, können wir testen, ob sich die beiden Mittelwerte signifikant unterscheiden, wenn Sie den t-Test verwenden.

Der t-Test ist jedoch nicht ausreichend, wenn mehr als zwei Mittel miteinander verglichen werden sollen. Zum Beispiel gibt es vier Mittel aus vier Gruppen. Um zu testen, ob diese vier Mittel signifikant voneinander abweichen, müssen sechs T-Tests durchgeführt werden.

Wenn die vier Mittel M 1, M 2, M 3, M 4 sind, müssen wir die Differenz zwischen M 1 und M 2, dh (M 1 - M 2 ), zwischen M 1 und M 3, dh (M 1 - M 3) vergleichen ) zwischen M 1 und M 4, dh (M 1 - M 4 ), zwischen M 2 und M 3, dh (M 2 - M 3 ), zwischen M 2 und M 4, dh (M 2 - M 4 ), zwischen M 3 und M 4 dh (M 3 - M 4 ). Ebenso müssen für 10 Mittel 45 t-Tests durchgeführt werden.

Für K bedeutet, dass wir K (K - 1) / 2 t - Tests machen müssen, und dies würde mehr Rechenaufwand und Arbeit erfordern. Durch Verwendung des F-Tests durch ANOVA können wir jedoch die Signifikanz der Differenz von drei oder mehr als drei Mitteln gleichzeitig bewerten.

Annahmen, auf denen ein F-Test beruht:

Wie üblich ist eine statistische Entscheidung insofern vernünftig, als in den verwendeten Daten bestimmte Annahmen getroffen wurden.

In der ANOVA werden normalerweise vier Anforderungen gestellt:

1. Die Probenahme innerhalb der Sätze sollte zufällig sein. Die verschiedenen Behandlungsgruppen werden zufällig aus der Bevölkerung ausgewählt.

2. Die Abweichungen innerhalb der verschiedenen Mengen müssen ungefähr gleich sein. Dies bezieht sich auf die Annahme einer Varianzhomogenität, dh die Gruppen sind in ihrer Variabilität homogen.

3. Beobachtungen innerhalb von experimentell homogenen Mengen sollten aus normalverteilter Population stammen.

4. Die Beiträge zur Gesamtvarianz müssen additiv sein.

A: Wir werden einige Beispiele aufgreifen und sehen, wie die Varianz analysiert wird, wenn Gruppen unabhängig sind:

Beispiel 5

In einem Versuchsaufbau werden 16 Probanden zufällig zwei Gruppen von je 8 Probanden zugeordnet. Diese zwei Gruppen wurden mit zwei verschiedenen Unterrichtsmethoden behandelt. Testen Sie die Signifikanz der Differenz zwischen den Stichprobenmitteln.

Lösung:

Gesamtsumme (dh Summe aller 16 Punkte) = 104 oder ∑X = 104

Großer Mittelwert (M), dh Mittelwert aller 16 Bewertungen = ∑X / N = 104/16 = 6, 5

Für die Berechnung des F-Verhältnisses müssen wir die folgenden Schritte ausführen:

Schritt 1:

Die Summe aller 16 Punkte ist 44 + 60 oder 104; und die Korrektur (C) ist dementsprechend

Schritt 2:

Wenn jede Bewertung beider Gruppen quadriert und summiert wird, wird ∑X 2 (∑X 1 2 + ∑X 2 2 = 260 + 460) 720.

Dann wird die Korrektur 676 unter Verwendung der folgenden Formel von der Summe abgezogen:

Gesamt SS oder SS 1 = ∑X 2 - C = 720 - 676 = 44.

oder SS t = 3 2 + 4 2 + 5 2 + ... + .. + 9 2 - 676 = 44

Schritt 3:

Die Summe der Quadrate zwischen den Mitteln SS b wird durch Quadrieren der Summe jeder Spalte ermittelt, wobei die erste und die zweite durch 8 getrennt werden und C subtrahiert wird.

Zwischen Gruppe SS oder SS b

Schritt 4:

Die SS innerhalb (oder SS W ) ist die Differenz zwischen SS t und SS b . Somit ist SS W = 44-16 = 28.

Schritt 5:

Da gibt es insgesamt 16 Noten

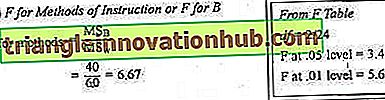

Interpretation des F-Verhältnisses:

Das Varianzverhältnis oder F ist 16/2 oder 8. Das df für Mittelwerte ist 1 und das df für Gruppen ist 14. Bei der Eingabe von Tabelle F mit diesen df's lesen wir in Spalte 1 und Zeile 14, dass der 0, 05-Pegel 4, 60 und ist das 0, 01-Niveau ist 8, 86. Unser berechnetes F ist bei 0, 05 signifikant.

Auf dem Niveau von 0, 01 ist dies jedoch nicht von Bedeutung. Mit anderen Worten, der beobachtete Wert von F ist größer als 0, 05 Pegelwert, aber kleiner als 0, 01 Pegelwert. Daraus schließen wir, dass der mittlere Unterschied auf dem Niveau von 0, 05 signifikant ist, aber nicht auf dem Signifikanzniveau von 0, 01.

Beispiel 6:

(Wenn die Gruppengrößen ungleich sind) Ein Zinstest wird 6 Jungen in einer Berufsausbildungsklasse und 10 Jungen in einer Lateinklasse erteilt.

Ist der mittlere Unterschied zwischen den beiden Gruppen auf der 0, 05-Ebene signifikant? Testen Sie die Signifikanz des Unterschieds durch ANOVA.

Interpretation des F-Verhältnisses:

Das Varianzverhältnis oder F beträgt 135/33 oder 4, 09. Der df für Zwischenmittel ist 1 und der df für Gruppen ist 14. Bei der Eingabe von Tabelle F mit diesen df's lesen wir in Spalte 1 und Zeile 14, dass der 0, 05-Pegel 4, 60 und der 0, 01-Pegel 8, 86 ist. Unser berechnetes F von 4, 09 erreicht nicht ganz den Wert von 0, 05, so dass unsere mittlere Differenz von 6 Punkten als nicht signifikant angesehen werden muss. Daher wird die Nullhypothese akzeptiert.

Wenn es nur zwei zu vergleichende Mittel gibt, wie hier; F = t 2 oder t = = √ F und die beiden Tests (F und t) ergeben genau das gleiche Ergebnis. Für das obige Beispiel ist √F = √4.09 = 2.02. Aus der Tabelle D haben wir herausgefunden, dass für .04 der 0, 05-Signifikanzwert für dieses t 2, 14 ist.

Unser t von 2, 02 erreicht diesen Wert nicht ganz und ist daher (wie F) nicht signifikant.

Beispiel 7:

(Mehr als zwei Gruppen)

Wenden Sie die ANOVA an, um zu testen, ob sich die Mittelwerte von vier Gruppen signifikant unterscheiden:

Da gibt es 20 Punkte in vier Gruppen:

df für die gesamte SS (oder SS 1 ) = (N - 1) oder 20 - 1 = 19

df für SS b = (K - 1) oder 4 - 1 = 3

df für SS w = (N - K) oder 20 - 4 = 16

F = 33, 33 / 3, 5 = 9, 52

T = √F = 3, 08

Interpretation des F-Verhältnisses:

Das Varianzverhältnis oder F beträgt 9, 52. Der df für Zwischenmittel ist 3 und der df für Gruppen ist 16. Bei der Eingabe von Tabelle F mit diesen df s lesen wir die Spalte 3 und Zeile 16, dass der 0, 05-Level 3, 24 und der 0, 01-Pegel 5, 29 ist.

Unser berechneter F von 9, 52 beträgt mehr als 5, 29. Daher ist F von Bedeutung. Die Nullhypothese wird mit der Schlussfolgerung zurückgewiesen, dass sich die vier Mittelwerte auf 01 deutlich unterscheiden.

(B) Wir werden ein anderes Beispiel zur Analyse der Varianz betrachten, wenn dieselbe Gruppe mehr als einmal gemessen wird, dh bei korrelierten Gruppen:

Wenn ein Test gegeben und dann wiederholt wird, kann eine Varianzanalyse verwendet werden, um zu bestimmen, ob die mittlere Änderung signifikant ist (dh die Signifikanz der Differenz zwischen den aus korrelierten Gruppen erhaltenen Mitteln).

Beispiel 8:

(Für korrelierte Gruppen)

Fünf Probanden erhalten vier aufeinanderfolgende Versuche nach einem Ziffernsymboltest, von denen nur die Ergebnisse für die Versuche 1 und 4 gezeigt werden. Ist der mittlere Gewinn von der ersten bis zur abschließenden Studie signifikant.

Die Verfahren zur Varianzanalyse unterscheiden sich derzeit auf mindestens zwei Arten von den oben diskutierten Verfahren.

Da die Möglichkeit besteht, dass eine Korrelation zwischen den von den fünf Probanden in der ersten und vierten Studie erzielten Bewertungen besteht, sollten die beiden Sätze von Bewertungen zunächst nicht als unabhängige (zufällige) Stichproben behandelt werden.

Zweitens bezieht sich die Einstufung nun auf zwei Kriterien: (a) Studien und (b) Probanden.

Aufgrund dieser zwei Kriterien muss die gesamte SS in drei Teile unterteilt werden:

(a) SS aufgrund von Versuchen;

(b) SS den Probanden zuzurechnen; und

(c) Eine restliche SS, die normalerweise als "Interaktion" bezeichnet wird.

Die Schritte zur Berechnung dieser drei Abweichungen können wie folgt zusammengefasst werden:

Schritt 1:

Korrektur (C). Wie im vorherigen Verfahren gilt C = ((X) 2 / N. Im obigen Beispiel ist C 90 2/10 oder 810.

Schritt 2:

Summe der Quadrate. Die Berechnung wiederholt wiederum die in den Beispielen 1, 2 und 3 angewendete Vorgehensweise.

Gesamt SS oder SS t = 7 2 + 8 2 + 4 2 + 6 2 + 5 2 + 10 2 + 15 2 + 5 2 + 20 2 + 10 2 - C

= 1040 - 810 oder 230.

Schritt 3:

SS zwischen den Mitteln der Versuche. Es gibt zwei Versuche mit jeweils 5 Punkten.

Deshalb,

Schritt 4:

SS unter den Mitteln der Probanden. Um das zweite Einstufungskriterium zu berücksichtigen, ist eine zweite Zwischenmittel-SS erforderlich. Es gibt 5 Schüler / Fächer und jedes hat zwei Prüfungen. Die Noten der 1. und 4. Prüfung jedes Probanden / Studenten werden addiert, um 17, 23, 9, 26, 15 zu erhalten.

Daher,

Schritt 5:

Interaktion SS. Die verbleibende Variation oder Interaktion ist das, was übrig bleibt, wenn die systematischen Auswirkungen von Versuchsunterschieden und Subjektunterschieden von der gesamten SS entfernt wurden.

Die Interaktion misst die Tendenz, dass die Leistung der Probanden mit den Studien variiert. Sie misst die Faktoren, die weder den Probanden noch den Prüfungen alleine zuzurechnen sind, sondern dass beide zusammen wirken.

Die Interaktion wird durch einfaches Abziehen der Versuche SS plus Probanden SS von der Gesamt-SS erhalten.

Somit,

Interaktion SS = SS t - (SS- Probanden + SS- Versuche ) = 230 - (90 + 90) = 50.

Schritt 6:

Da es insgesamt 10 Punkte gibt, haben wir (10 - 1) oder 9 df für die gesamte SS. Zwei Studien erhalten 1 df und 5 Probanden 4. Die restlichen 4 df werden der Interaktion zugewiesen. Die Regel ist, dass der df für die Interaktion das Produkt des df für die zwei interagierenden Variablen ist, hier 1 x 4 = 4. Im Allgemeinen ist N die Gesamtzahl der Bewertungen, r = Zeilen und K = Spalten.

Interpretation der F-Verhältnisse:

Das F für Studien ist 7.2. Der berechnete Wert von F für Versuche ist weniger als 7, 71, den wir in Tabelle F für den 0, 05-Punkt gelesen haben, wenn df 1 = 1 und df 2 = 4 ist.

Dies bedeutet, dass die Nullhypothese in Bezug auf Studien haltbar ist und akzeptiert werden muss. Es gibt deutliche Beweise dafür, dass keine signifikanten Verbesserungen von Versuch 1 zu Versuch 4 stattfanden.

Das F für Probanden ist 1, 8 und ist viel kleiner als der 0, 05-Punkt von 6, 39 in Tabelle F für df 1 = 4 und df 2 = 4. Es ist offensichtlich, dass die Probanden nicht konstant besser sind als andere.

Dies bedeutet, dass die Nullhypothese in Bezug auf Subjekte haltbar ist und akzeptiert werden muss.

Zweiweg-ANOVA:

Um ein bestimmtes geometrisches Konzept zu vermitteln, wenn unterschiedliche Unterrichtsmethoden auf zwei oder mehr als zwei Schülergruppen angewendet werden, nennen wir es eine experimentelle Variable.

Bei der Einweg-ANOVA wird nur ein Faktor (dh eine unabhängige Variable) untersucht. Wenn wir zum Beispiel testen wollen, ob Unterrichtsmethoden Auswirkungen auf die Leistung haben, untersuchen wir die Auswirkung einer unabhängigen Variablen (dh Methodenlehre) auf die abhängige Variable (dh Leistung).

Die Datensätze werden anhand einer experimentellen Variante unterschieden. Es gibt nur ein Prinzip der Klassifizierung, einen Grund, Daten in Mengen aufzuteilen.

Dazu wählen wir drei Gruppen nach dem Zufallsprinzip aus und weisen diesen drei Gruppen nach dem Zufallsprinzip drei verschiedene Behandlungen, dh Methode-1, Methode-2 und Methode-3, zu.

Am Ende können die Leistungsbewertungen der Probanden der drei verschiedenen Gruppen durch einen entsprechenden Test ermittelt werden.

Dann können wir mit ANOVA testen, ob sich die Mittelwerte dieser drei Gruppen signifikant unterscheiden.

In einer Zwei-Wege-Klassifizierung oder Zwei-Wege-ANOVA gibt es zwei verschiedene Klassifizierungsgrundlagen. Zwei Versuchsbedingungen können von Gruppe zu Gruppe variieren. In den psychologischen Laboratorien können verschiedene künstliche Flugfeld-Landebahnen mit jeweils unterschiedlichen Markierungen durch einen Diffusionsschirm betrachtet werden, um die Sicht durch Nebel auf verschiedenen Opakebenen zu stimulieren.

Bei einem pädagogischen Problem können vier Lehrmethoden eines bestimmten geometrischen Konzepts von fünf verschiedenen Lehrern angewendet werden, wobei jede die vier Methoden verwendet. Es würde also 20 Kombinationen von Lehrer und Methode geben.

Die folgende Tabelle kann Ihnen weiter vorangehen:

In einem unten angeführten Beispiel werden die Auswirkungen von drei Unterrichtsmethoden auf Leistungsbewertungen untersucht. Es wird jedoch erwartet, dass sich die Unterrichtsmethoden je nach sozioökonomischem Status (SES) der Probanden unterschiedlich auswirken werden.

Wir können also eine Studie entwerfen, in der die Wirkung zweier Variablen, dh die Wirkung von Unterrichtsmethoden und die Wirkung des sozioökonomischen Status (SES), gleichzeitig untersucht werden kann. In diesem Design können wir auch den Interaktionseffekt untersuchen. Für solche Konstruktionen werden die Techniken der Zweiweg-ANOVA verwendet.

Beispiel 9:

Sechs Gruppen von Studenten (jeweils fünf Studenten) wurden für sechs Behandlungsbedingungen nach dem Zufallsprinzip ausgewählt. Untersuchen Sie für das folgende Beispiel die Wirkung zweier Faktoren, nämlich Faktor A (sozioökonomischer Status) und Faktor B (Unterrichtsmethoden).

Lösung:

Im obigen Beispiel haben wir zwei Stufen von SES genommen, nämlich High SES in der Kategorie A 1 und Low SES in der Kategorie A 2 und drei Unterrichtsmethoden, nämlich B 1 (Vorlesung), B 2 (Diskussion) und B 3 ( Spielweise).

Die Gesamtzahl der Behandlungen im Experiment beträgt 2 × 3 = 6. Hier ist n = 5 und die Gesamtzahl der Beobachtungen ist N = 5 × 6 = 30.

Gesamtsumme ∑X = 30 + 50 + 40 + 25 + 45 + 35 = 225.

Sechs verschiedene Behandlungsgruppen können in einer "Interaktionstabelle" dargestellt werden, wie unten angegeben:

Für drei Instruktionsmethoden gibt es drei Spalten (... c = 3). Die Zeilensummen werden zur Berechnung von SS für A (SES) verwendet. Die Spaltensummen werden für die Berechnung von SS für B (Unterrichtsmethoden) verwendet.

Schritte zur Berechnung von Abweichungen können wie folgt zusammengefasst werden:

Schritt 1:

Schritt 2:

Gesamt SS oder SS t = ∑X 2 - C. Hier werden alle dreißig Punkte quadriert und addiert und C wird abgezogen.

SSt = 5 2 + 7 2 + ... + 10 2 + 7 2 - 1687, 5 = 1919 - 1687, 5 = 231, 5

Schritt 3:

Zwischen Gruppe SS oder SS b = Summe von (∑X) 2 / n für alle sechs Behandlungsbedingungen - C.

Schritt 4:

Innerhalb der Gruppen SS oder SS W = SS t - SS b = 231, 5 - 87, 5 = 144

Schritt 5:

Nun kann "Between Group SS" oder SS b von 87.5 in drei Teile aufgeteilt werden, nämlich SS A, SS B und SS AB, dh SS b = SS A + SS B + SS AB

Wobei SS A = SS des Faktors A (SES), der aus der Abweichung von A 1 und A 2 generiert wird, bedeutet aus dem Mittelwert der Gesamtbewertungen.

SS B = SS des Faktors B (Methoden), der aus den Abweichungen von B 1, B 2 und B 3 erzeugt wird, bedeutet vom Mittelwert der Gesamtpunktzahl.

Schritt 6:

Freiheitsgrade für verschiedene SS

In unserem Problem haben wir 6 Gruppen

.˙. K = 6

n = 5 und N = 6 xn = 6 x 5 = 30.

In der Interaktionstabelle gibt es zwei Zeilen und drei Spalten

.˙. r = 2 und C = 3.

Die Partitionierung von df kann wie folgt durchgeführt werden:

df für SS t = N - 1 = 30 - 1 oder 29

df für SS b = K - 1 = 6 - 1 oder 5

df für SS W = K (n - 1) = 6 x 4 oder 24

Der df fox SS b kann in drei Teile unterteilt werden:

(i) df für SSA = r - 1 = 2 - 1 oder 1

(ii) df für SSB = c - 1 = 3 - 1 oder 2

(iii) df für SS AB = (r - 1) (C - 1) = 1 x 2 oder 2

Jetzt können wir die obige Berechnung in eine bidirektionale ANOVA-Übersichtstabelle eingeben:

Interpretation des F-Verhältnisses:

(a) F für SES oder F für A

F = MS A / MS W = 7, 5 / 6, 0 = 1, 25

(0, 052 ist weniger als eins)

Als F von 1, 25 <4, 26 auf dem Niveau von 0, 05 behalten wir die Nullhypothese bei, dass die beiden zufällig ausgewählten Gruppen sich auf der Grundlage des sozioökonomischen Status nicht nach Leistungswerten unterscheiden.

Als F von 6, 67> 5, 6 auf .01 lehnen wir die Nullhypothese ab. Wir schließen daraus, dass die drei Unterrichtsmethoden die Leistungswerte unterschiedlich beeinflussen.

Als F von 0, 00 <1 behalten wir die Nullhypothese bei. Wir akzeptieren die Nullhypothese, keine Interaktion. Wir schließen daraus, dass die Wirksamkeit von Methoden nicht vom sozioökonomischen Status abhängt.